KI ist mit vielen Begriffen verbunden. Wir haben ein Glossar mit allem, was Sie wissen müssen

GPU? TPU? LLM? Alle wichtigen KI-Vokabular, das Sie kennen müssen

Wenn sich Menschen, die mit KI nicht vertraut sind, vorstellen künstliche Intelligenz, können sie sich Will Smiths Blockbuster vorstellen Ich, Roboter, der Science-Fiction-Thriller Ex Machina, oder der Disney-Film SmartHaus – alptraumhafte Szenarien, in denen intelligente Roboter die Macht übernehmen und ihre menschlichen Gegenstücke in den Untergang treiben.

Die heutigen generativen KI-Technologien sind noch nicht allmächtig. Sicher, sie sind vielleicht in der Lage, Desinformation säen, um Wahlen zu manipulieren oder Geschäftsgeheimnisse teilen. Aber die Technologie steckt noch in der Frühphase und Chatbots machen immer noch große Fehler.

Dennoch bringt die Neuheit der Technologie auch neue Begriffe ins Spiel. Was macht überhaupt einen Halbleiter aus? Wie unterscheidet sich generative KI von allen anderen Arten künstlicher Intelligenz? Und sollten Sie die Nuancen zwischen einer GPU, einer CPU und einer TPU wirklich kennen?

Wenn Sie mit dem neuen Fachjargon, der in der Branche verwendet wird, Schritt halten möchten, hat Quartz einen Leitfaden zu den wichtigsten Begriffen.

2 / 15

Was ist generative KI?

Beginnen wir zur Auffrischung mit den Grundlagen. Generative künstliche Intelligenz ist eine Kategorie der KI, die Daten verwendet, um originelle Inhalte zu erstellen. Im Gegensatz dazu klassische KI könnte nur Vorhersagen liefern basierend auf Dateneingaben, nicht auf brandneuen und einzigartigen Antworten durch maschinelles Lernen. Aber Generative KI verwendet “Deep Learning – Lernen mit Tiefgang„, eine Form des maschinellen Lernens, bei der künstliche neuronale Netzwerke (Softwareprogramme) verwendet werden, die dem menschlichen Gehirn ähneln, sodass Computer menschenähnliche Analysen durchführen können.

Generative KI greift sich die Antworten allerdings nicht aus dem Nichts. Sie generiert Antworten auf der Grundlage von Daten, mit denen sie trainiert wurde. Dazu können Text, Video, Audio und Codezeilen gehören. Stellen Sie sich vor, Sie wachen mit verbundenen Augen aus dem Koma auf und können sich nur an 10 Wikipedia-Artikel erinnern. Alle Ihre Gespräche mit einer anderen Person über Ihr Wissen basieren auf diesen 10 Wikipedia-Artikeln. So ähnlich ist es – nur dass generative KI Millionen solcher Artikel und noch viel mehr verwendet.

3 / 15

Was ist ein Chatbot?

KI-Chatbots sind Computerprogramme, die Generieren Sie menschliche Gespräche mit Benutzernund geben einzigartige, originelle Antworten auf ihre Fragen. Chatbots wurden durch ChatGPT von OpenAI populär gemacht, und seitdem sind viele weitere hinzugekommen: Google Gemini, Microsoft CoPilot und Einstein von Salesforce sind unter anderem die Spitzenreiter.

Chatbots generieren nicht nur Textantworten — sie können auch Websites erstellen, Datenvisualisierungen erstellen, beim Codieren helfen, Bilder erstellen und Dokumente analysieren. Sicher sind KI-Chatbots noch nicht narrensicher — Sie haben bereits viele Fehler gemacht. Aber mit der schnellen Entwicklung der KI-Technologie wird auch die Qualität dieser Chatbots verschlechtern.

4 / 15

Was ist ein Large Language Model (LLM)?

Large Language Models (LLMs) sind eine Art generativer künstlicher Intelligenz. Sie werden anhand großer Daten- und Textmengen trainiert, darunter aus Nachrichtenartikeln und E-Books, um Inhalte zu verstehen und zu generieren, einschließlich natürlicher Sprache Text. Im Grunde werden sie an einer Menge Text trainiert, damit sie vorhersagen können, welches Wort als nächstes kommt. Nehmen diese Erklärung von Google:

„Wenn Sie anfängen , den Satz „Mary kickte einen…“ einzugeben, könnte ein mit genügend Daten trainiertes Sprachmodell vorhersagen: „Mary kickte einen Ball.“ Ohne genügendes Training könnte es nur ein „rundes Objekt“ oder nur die Farbe „gelb“ liefern.“ — Googles Erklärer

Beliebte Chatbots wie ChatGPT von OpenAI und Gemini von Google, die über Funktionen wie das Zusammenfassen und Übersetzen von Text verfügen, sind Beispiele für LLMs.

5 / 15

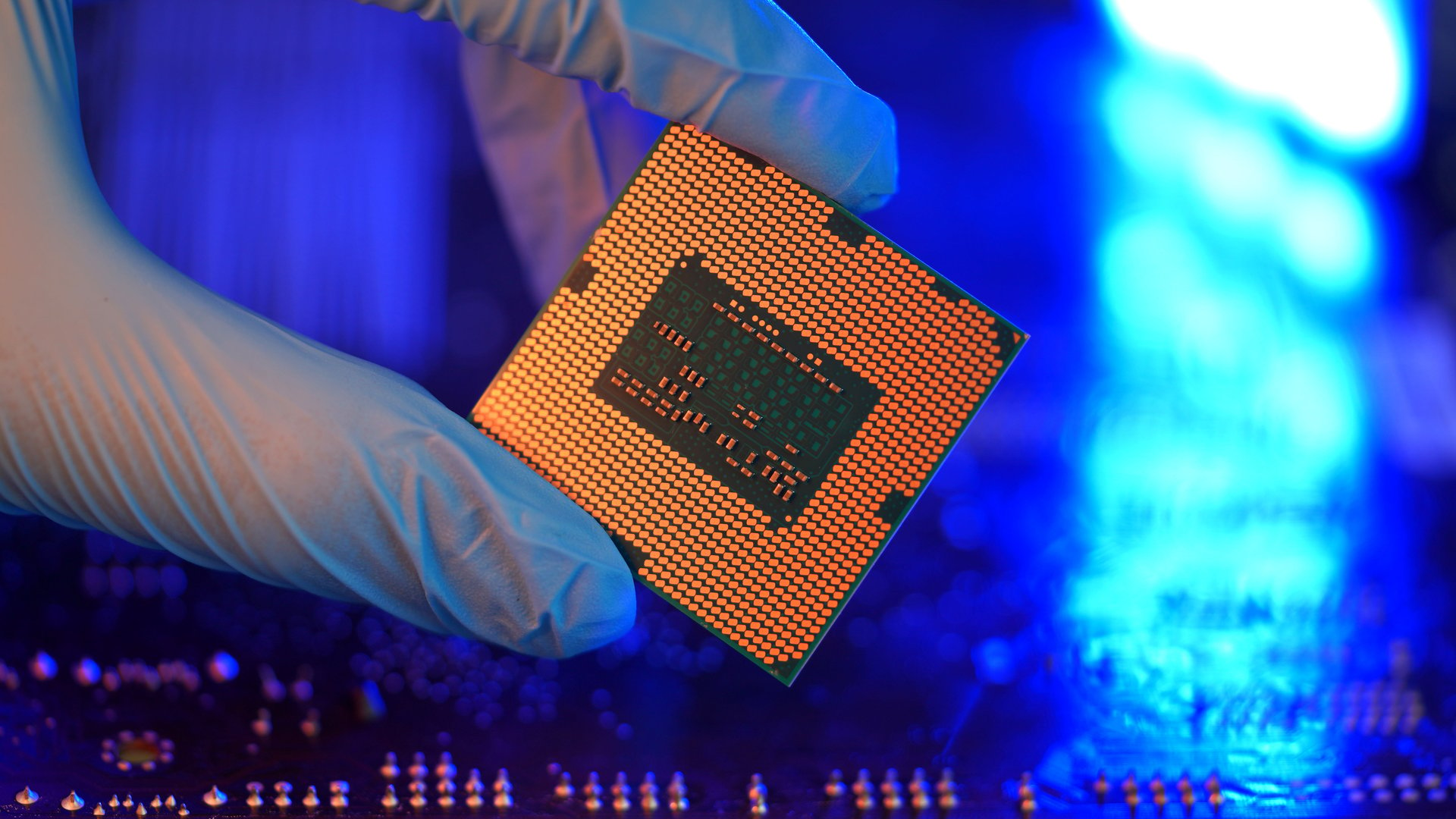

Was ist ein Halbleiter?

Nein, es ist kein 18-Wheeler-Fahrer. Halbleiter, auch bekannt als KI-Chips, werden in elektrischen Schaltkreisen von Geräten wie Telefonen und Computern verwendet. Elektronische Geräte würden ohne Halbleiter nicht existieren, die aus reinen Elementen wie Silizium oder Verbindungen wie Galliumarsenid hergestellt sind, um Strom zu leiten. Der Name „Halbleiter“ kommt davon ab, dass das Material mehr Strom leiten kann als ein Isolator aber weniger Strom leitet als ein reiner Leiter wie Kupfer.

Die weltgrößte Halbleitergießerei, Taiwan Semiconductor Manufacturing Company (TSMC), stellt einen schätzungsweise 90 % der modernen Chips der Welt und zählt die Top-Chipdesigner Nvidia und Advanced Micro Devices (AMD) zu seinen Kunden.

Obwohl Halbleiter wurden in den USA erfunden, produziert es mittlerweile etwa 10% der weltweiten Chips, ohne die fortgeschrittenen Chips die für größere KI-Modelle benötigt werden. Präsident Joe Biden unterzeichnete 2022 den CHIPS and Science Act die Chipherstellung zurück in die USA zu bringen, und die Biden-Regierung hat bereits Milliarden in Halbleiterunternehmen investiert, darunter Intel und TSMC Fabriken im ganzen Land zu bauen. Ein Teil dieser Bemühungen hat auch damit zu tun, Chinas Fortschritten bei der Chipherstellung und KI-Entwicklung entgegenzuwirken.

6 / 15

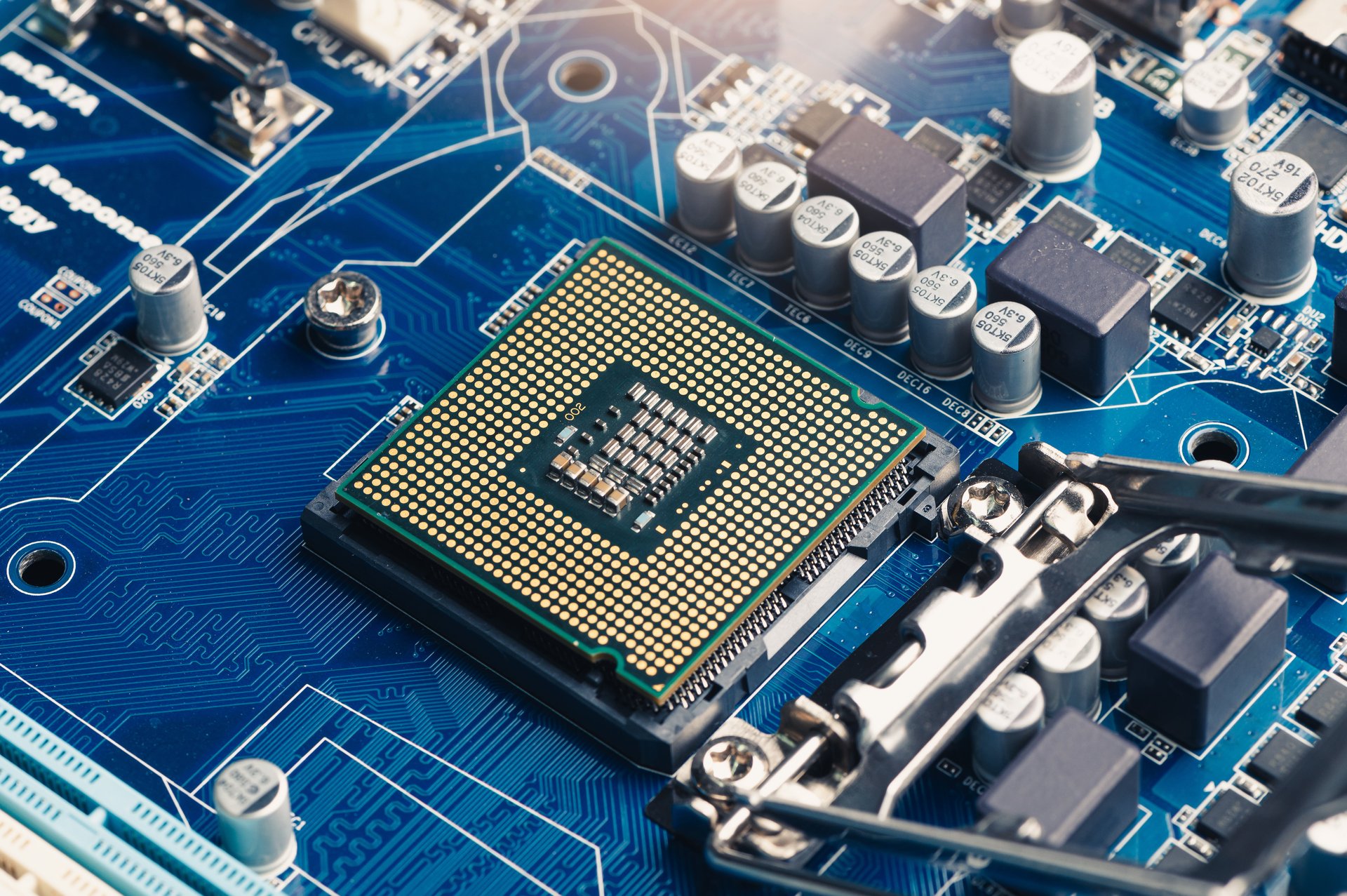

Was sind GPUs und CPUs?

Eine GPU ist eine Grafikverarbeitungseinheit, ein fortschrittlicher Chip (oder Halbleiter), der die großen Sprachmodelle hinter KI-Chatbots wie ChatGPT antreibt. wird traditionell zur Erstellung von Videospielen mit hochwertigerer Grafik verwendet.

Dann ein ukrainisch-kanadischer Informatiker, Alex Krizhevsky, zeigte, wie mit einer GPU Deep-Learning-Modelle um alles schneller betrieben werden können als eine CPU — eine zentrale Verarbeitungseinheit oder die Haupthardware, die Computer antreibt.

CPUs sind das „Gehirn“ eines Computers, Ausführen von Anweisungen, damit der Computer funktioniert. Eine CPU ist ein Prozessor, welche liest und interpretiert Softwareanweisungen, um die Funktionen des Computers zu steuern. Eine GPU ist jedoch ein Beschleuniger, ein Stück Hardware, das entwickelt wurde um eine bestimmte Funktion eines Prozessors zu verbessern.

Nvidia ist der führende GPU-Designer, dessen H100- und H200-Chips in den Rechenzentren großer Technologieunternehmen zum Betrieb von KI-Software eingesetzt werden. Andere Unternehmen wollen mit den Beschleunigern von Nvidia konkurrieren, darunter Intel mit seinem Gaudi 3-Beschleuniger und Microsofts Azure Maia 100-GPU.

7 / 15

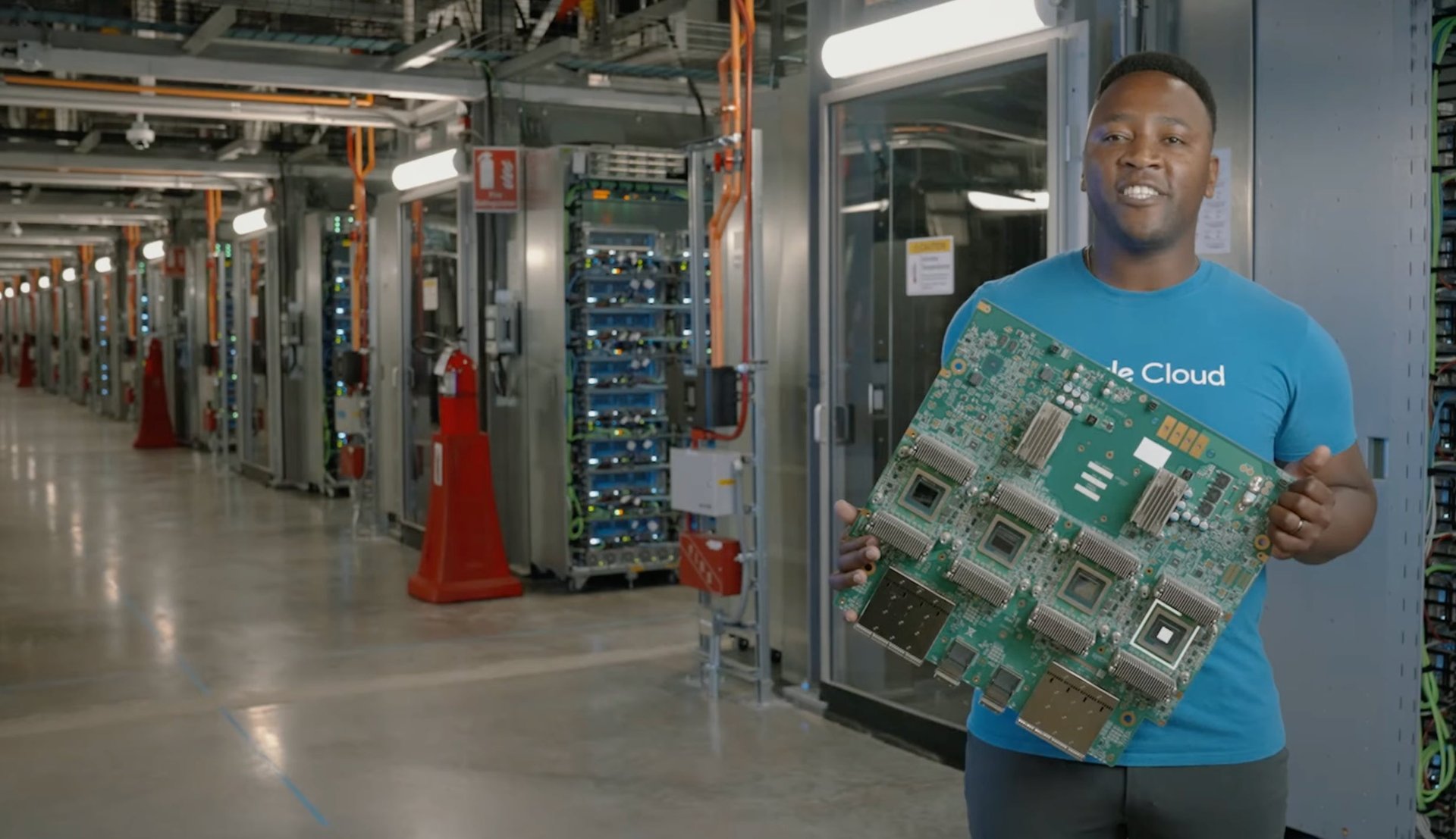

Was ist ein TPU?

TPU steht für „Tensor Processing Unit“. Im Gegensatz zu denen von Microsoft und Nvidia handelt es sich bei den Chips von Google um TPUs – speziell entwickelte Chips, die speziell für das Training großer KI-Modelle entwickelt wurden (wohingegen GPUs ursprünglich für Spiele und nicht für KI entwickelt wurden).

CPUs sind Allzweckprozessoren, GPUs sind zusätzliche Prozessoren, die High-End-Aufgaben ausführen. TPUs sind maßgeschneiderte Beschleuniger für die Ausführung von KI-Diensten —und macht sie umso leistungsfähiger.

8 / 15

Was ist eine Halluzination?

Wie bereits erwähnt, sind KI-Chatbots zu vielen Aufgaben fähig, aber ihnen machen auch häufig Fehler. Wenn LLMs wie ChatGPT falsche oder unsinnige Informationen erfinden, das nennt eine Halluzination.

Chatbots „halluzinieren“, wenn sie nicht über die notwendigen Trainingsdaten verfügen, um eine Frage zu beantworten, aber trotzdem eine Antwort generieren, die wie eine Tatsache aussieht. Halluzinationen können durch verschiedene Faktoren verursacht werden, wie ungenaue oder verzerrte Trainingsdaten und Overfitting, das dann zu einer Überanpassung führt . Algorithmus kann keine Vorhersagen oder Schlussfolgerungen machen aus anderen Daten als denen mit denen es trainiert wurde.

Halluzinationen sind derzeit eines der größten Probleme bei generativen KI-Modellen – und sie sind nicht ganz einfach zu lösen für. Da KI-Modelle an großen Datenmengen trainiert werden, kann es schwierig sein, spezifische Probleme in den Daten zu finden. Manchmal sind die zum Training von KI-Modellen verwendeten Daten ohnehin ungenau, weil sie kommt von Orten wie Reddit. Obwohl KI-Modelle darauf trainiert werden, keine Antwort auf Fragen zu beantworten, auf deren Antwort sie keine Antwort wissen, lehnen sie diese Fragen manchmal nicht ab, sondern generieren stattdessen ungenaue Antworten.

9 / 15

Was ist Training?

Beim Training wird einem KI-Modell beigebracht, wie es Vorhersagen treffen kann. In dieser Phase wird ein KI-Modell mit Daten gefüttert, damit es lernt, eine oder mehrere bestimmte Aufgaben auszuführen. Anschließend durchläuft es ein Versuch-und-Irrtum-Verfahren, bis es die gewünschten Ergebnisse liefert.

10 / 15

Was ist Inferenz?

Inferenz erfolgt nach dem Training und ist der Prozess, bei dem ein trainiertes KI-Modell Vorhersagen auf der Grundlage neuer Daten trifft. Beispielsweise kann ein selbstfahrendes Auto darauf trainiert werden, ein Stoppschild auf einer bestimmten Straße zu erkennen. Durch Inferenz wäre das selbstfahrende Auto in der Lage, erkennen Sie ein Stoppschild auf jeder Straße.

11 / 15

Was ist Retrieval-Augmented-Generation (RAG)?

Retrieval-Augmented Generation (RAG) ist eine Technik der natürlichen Sprachverarbeitung (NLP), die zur Verbesserung der Genauigkeit generativer KI-Modelle verwendet wird. Bei RAG werden generative große Sprachmodelle mit Informationsabrufsystemen (wie Datenbanken und Webseiten) kombiniert, sodass die Modelle auf Wissen außerhalb ihrer ursprünglichen Trainingsdaten verweisen und daher aktuellere Antworten liefern können.

Der Begriff wurde geprägt in einem 2020 -Papier von einer Gruppe von Forschern von Facebook, University College London und New York University.

12 / 15

Was sind Token?

Textdaten werden in kleinere Einheiten, sogenannte Token, zerlegt, um von KI-Modellen verarbeitet zu werden. Token können von einem einzelnen Buchstaben bis hin zu einer ganzen Phrase reichen.

13 / 15

Was sind Parameter?

Parameter sind die Variablen, die ein Modell aus Trainingsdaten lernt und die seine Fähigkeit, Vorhersagen zu treffen, steuern. Während des Trainingsprozesses passt ein Modell seine Parameter an, um die Lücke zwischen seiner Vorhersage und dem gewünschten Ergebnis zu schließen. Auf diese Weise lernt das Modell, wie es auf der Grundlage neuer Daten genaue Vorhersagen treffen kann.

14 / 15

Was ist ein KI-PC?

Ein AI-PC ist ein Personal Computer, der KI- und maschinelle Lernaufgaben bewältigen kann. Sie sind mit einer CPU, GPU und NPU ausgestattet, die spezifische KI Fähigkeiten. Eine NPU oder Neural Processing Unit ist ein Chip, der darauf spezialisiert ist, KI- und Maschinenlern-basierte Aufgaben auf dem Computer auszuführen, ohne die zu verarbeitenden Daten in die Cloud senden zu müssen.

15 / 15

Was ist eine neuronale Verarbeitungseinheit (NPU)?

Eine Neural Processing Unit (NPU) kann Aufgaben der künstlichen Intelligenz und des maschinellen Lernens direkt auf einem Gerät wie etwa einem KI-PC ausführen, sodass die Daten zur Verarbeitung nicht an die Cloud gesendet werden müssen.